«تجارت نیوز» گزارش میدهد:

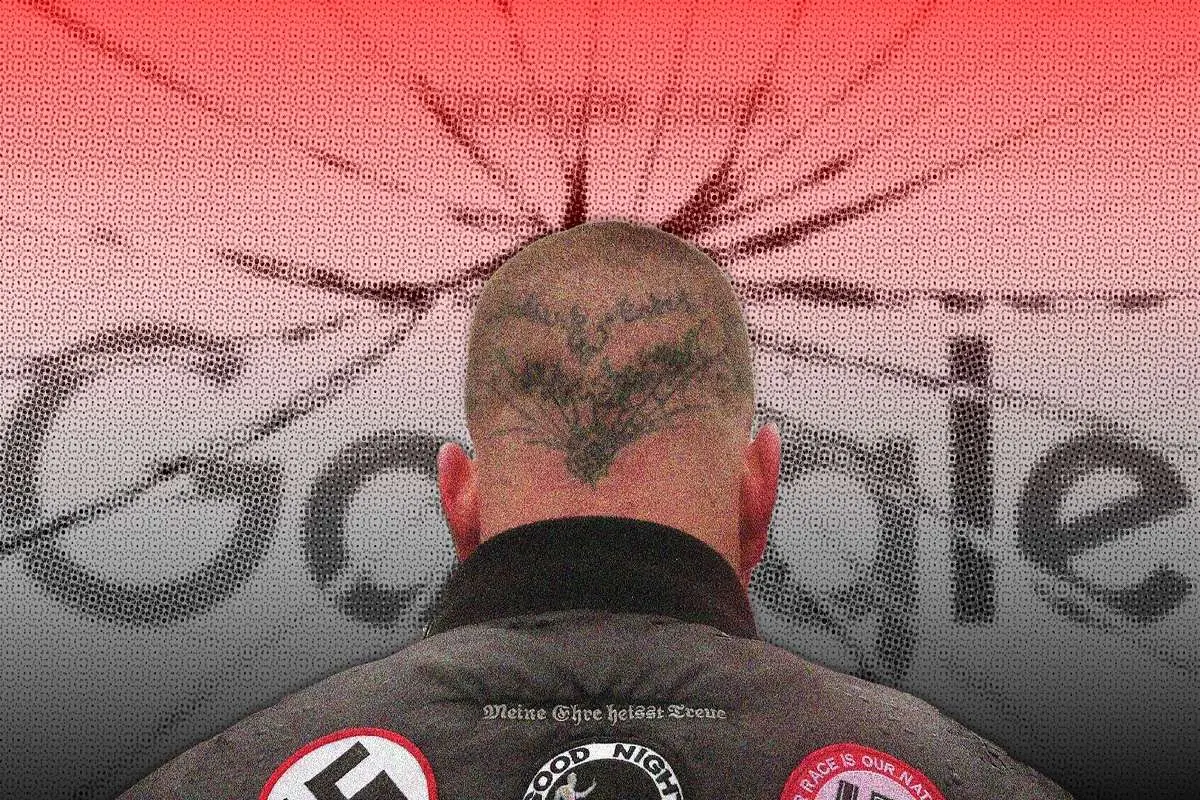

اتهام نژادپرستی علمی به گوگل، مایکروسافت و پرپلکسی

گوگل، مایکروسافت و پرپلکسی بهدلیل نمایش اطلاعات نژادپرستانه درباره برتری نژادی در هوش مصنوعی با انتقادات شدید مواجه شدهاند و نگرانیهایی ایجاد کردهاند.

پاتریک هرمانسون، محقق سازمان بریتانیایی Hope Not Hate که در زمینه مبارزه با نژادپرستی فعالیت میکند، این مسئله را در جریان تحقیقاتی درباره جنبش مجدد نژادپرستی علمی کشف کرد. او به دنبال اطلاعات در مورد یک پایگاه داده بود که ادعا میکند نمرات IQ میتواند به اثبات برتری نژاد سفید کمک کند. نتیجه جستجوی او به نمایش دادههایی منجر شد که این اطلاعات را به عنوان دادههای معتبر نشان میدادند.

مرکز تنوع انسانی (Human Diversity Foundation)، یک سازمان نژادپرستی علمی که توسط میلیاردر فناوری آمریکایی اندرو کنرو تأمین مالی میشود، در مرکز تحقیقات هرمانسون قرار دارد. این سازمان در سال 2022 تأسیس شده و جانشین "صندوق پیشگام" است که در سال 1937 توسط همدستان نازیها در ایالات متحده با هدف ترویج "بهبود نژادی" و "واقعگرایی نژادی" بنیانگذاری شد. هرمانسون زمانی که متوجه شد ابزار جستجوی هوش مصنوعی گوگل اطلاعاتی که او قصد داشت حذف کند را به او نمایش میدهد، شوکه شد.

تبلیغ اطلاعات حذفشده توسط هوش مصنوعی

در جریان جستجوی ملی IQها، هرمانسون با ابزار هوش مصنوعی گوگل که بهطور پیشفرض فعال است، مواجه شد. این ابزار به او ارقام خاصی را برای کشورهای مختلف نشان داد. بهعنوان مثال، گوگل IQ متوسط 80 را برای پاکستان و07/45 را برای سیرالئون گزارش داد. هرمانسون متوجه شد که این ارقام مستقیماً از دادههای ریچارد لین، یک آکادمیسین جنجالی و رئیس سابق صندوق پیشگام، استخراج شده است. کار لین به دلیل روشهای نادرست و نتایج نژادپرستانهاش بهطور گستردهای رد شده است.

مجله وایرد (WIRED) نیز این یافتهها را تأیید کرد و متوجه شد که سایر موتورهای جستجوی هوش مصنوعی مانند کوپایلت، مایکروسافت و پرپلکسی نیز به اطلاعات حذفشده لین اشاره میکنند. این افشاگریها نگرانیهایی را در بین کارشناسان برانگیخته است که نگرانند فناوری هوش مصنوعی ناخواسته ایدئولوژیهای افراطی را از طریق تبلیغ تحقیقات علمی نادرست ترویج کند.

ربکا سیر، مدیر مرکز فرهنگ و تکامل در دانشگاه برونل لندن، تأکید کرد که استفاده از این دادههای نادرست نه تنها اطلاعات غلط را گسترش میدهد، بلکه به دستور کار سیاسی نژادپرستی علمی کمک میکند.

ابزارهای جستجوی هوش مصنوعی گوگل که اوایل سال جاری به عنوان بخشی از تغییرات جدید جستجوی این شرکت معرفی شدند، خلاصههایی از نتایج جستجو را بدون نیاز به کلیک روی لینکهایی تولید میکنند. اما این سیستم همیشه منابع دادههای خود را به وضوح نشان نمیدهد.

در مورد امتیازات IQ ملی، ابزار هوش مصنوعی گوگل از منابع مشکوکی از جمله پستهای رسانههای اجتماعی و وبسایتهای نامعتبر اطلاعات جمعآوری کرده بود.

مشکلات در سایر موتورهای جستجوی هوش مصنوعی

وایرد در آزمایش موتورهای جستجوی هوش مصنوعی دیگر متوجه مشکلات مشابهی شد. پرپلکسی که به دلیل ایجاد اطلاعات ساختگی مورد انتقاد قرار گرفته به تحقیقات لین در پاسخ به پرسشهای مربوط به IQ ملی اشاره کرد. کوپایلت و مایکروسافت نیز ارقام IQهایی را ارائه میکرد که در نهایت به کارهای لین مربوط میشد.

گوگل مشکل را پذیرفت و اعلام کرد که سیستمهای آن طبق انتظار عمل نمیکردهاند و مطالب نادرست حذف شدهاند. این شرکت تأکید کرد که ابزارهای حفاظتی برای جلوگیری از پاسخهای بیکیفیت دارد و در حال کار بر بهبود محتوای تولید شده توسط هوش مصنوعی است. با این حال، حتی پس از خاموش شدن ابزارهای جستجوی هوش مصنوعی برای برخی پرسشها، موتور جستجوی گوگل همچنان مطالبی را نشان میداد که به دادههای نادرست لین اشاره میکرد.

انتقادات نسبت به پایگاه دادههای بیکیفیت

یکی از مسائل اصلی مطرح شده در این جنجال، کیفیت ضعیف مجموعه دادههای لین است که توسط کارشناسان به شدت مورد انتقاد قرار گرفته است. تخمینهای لین برای ارقام IQ ها بر اساس نمونههای کوچک و غیرنماینده است و اغلب نسبت به کشورهای غیرغربی مغرضانه است. بهعنوان مثال، برآورد لین برای IQ ملی آنگولا بر اساس تنها 19 نفر و دادههای او برای اریتره از کودکان یتیم خانهها گرفته شده است.

برای دههها کار لین توسط افراطگرایان راستگرا و نژادپرستان سفیدپوست برای توجیه ایدئولوژیهای نژادپرستانه استفاده شده است. دادههای نادرست او به نقشهای رنگی تبدیل شده که بهطور گستردهای در رسانههای اجتماعی به اشتراک گذاشته میشود و کشورهای آفریقایی را با IQهای پایین به رنگ قرمز نشان میدهد، در حالی که کشورهای غربی به رنگ آبی نمایش داده میشوند.

کارشناسانی مانند آدام رادرفورد معتقدند که گسترش ایدههای لین نه تنها تقصیر سیستمهای هوش مصنوعی بلکه مقصر دانشگاهها نیز است. تحقیقات لین صدها بار در مقالات دانشگاهی ذکر شده که به کارهای او مشروعیت بخشیده است. رادرفورد معتقد است که پذیرش تحقیقات لین توسط برخی محافل دانشگاهی باعث شده که این افکار به راحتی در سیستمهای هوش مصنوعی پخش شوند.

با ادامه تغییرات هوش مصنوعی در نحوه دسترسی افراد به اطلاعات، نگرانیها درباره نقش این سیستمها در تبلیغ ایدههای خطرناک و رد شده افزایش یافته است. جامعه علمی و شرکتهای فناوری باید مسئولیت اطمینان از جلوگیری از گسترش اطلاعات نادرست و مضر را بر عهده بگیرند، بهویژه زمانی که این اطلاعات پتانسیل رادیکالسازی افراد و تغذیه ایدئولوژیهای افراطی را دارند.

امین ربیعی

امین ربیعی

نظرات