به گزارش تجارت نیوز، مدلهای هوش مصنوعی تازهتأسیس شده o3 و o4-mini شرکت OpenAI در بسیاری از جنبهها بهروز و پیشرفته هستند. با این حال، این مدلهای جدید همچنان دچار توهم میشوند و اطلاعات نادرست تولید میکنند. در واقع، نرخ توهمات در این مدلها بیشتر از چندین مدل قدیمیتر OpenAI است. توهمات بهعنوان یکی از بزرگترین و مشکلترین چالشها در زمینه هوش مصنوعی شناخته میشوند و حتی بر روی بهترین سیستمهای موجود امروز نیز تأثیر میگذارند.

وضعیت توهمات در مدلهای جدید

در تاریخچه توسعه مدلهای هوش مصنوعی، هر مدل جدید بهطور معمول در زمینه توهمات اندکی بهبود یافته و نسبت به مدلهای قبلی کمتر دچار توهم میشود. اما بهنظر میرسد که در مورد o3 و o4-mini این قضیه صدق نمیکند. طبق آزمایشهای داخلی OpenAI، این دو مدل که بهعنوان مدلهای استدلالی شناخته میشوند، نسبت به مدلهای قبلی استدلالی این شرکت، یعنی o1، o1-mini و o3-mini، و همچنین مدلهای سنتی «غیراستدلالی» مانند GPT-4o، بیشتر دچار توهم میشوند.

دلیل افزایش توهمات

نگرانی بیشتری وجود دارد زیرا سازنده ChatGPT بهطور دقیق نمیداند که چرا این افزایش در توهمات اتفاق میافتد. در گزارش فنی OpenAI برای o3 و o4-mini، اشاره شده است که «تحقیقات بیشتری لازم است» تا دلیل بدتر شدن توهمات در مقیاسگذاری مدلهای استدلالی را درک کنند. هرچند o3 و o4-mini در برخی زمینهها، از جمله وظایف مربوط به کدنویسی و ریاضیات، عملکرد بهتری دارند، اما به دلیل اینکه «ادعاهای بیشتری بهطور کلی ایجاد میکنند»، در نتیجه به «ادعاهای دقیقتر و همچنین ادعاهای نادرست/توهمی بیشتری» میرسند.

نتایج آزمایشها

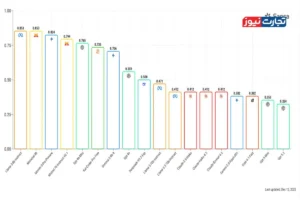

OpenAI دریافت که o3 در پاسخ به 33 درصد از سؤالات در آزمون PersonQA، که معیاری داخلی برای اندازهگیری دقت اطلاعات مدل درباره افراد است، توهم تولید کرده است. این نرخ تقریباً دو برابر نرخ توهمات مدلهای قبلی استدلالی OpenAI، یعنی o1 و o3-mini، که به ترتیب 16 درصد و 14.8 درصد بودند. o4-mini حتی در آزمون PersonQA بدتر عمل کرده و 48 درصد از زمان دچار توهم شده است.

شواهد از آزمایشهای مستقل

آزمایشهای مستقل توسط Transluce، یک آزمایشگاه تحقیقاتی غیرانتفاعی در زمینه هوش مصنوعی، همچنین شواهدی را نشان داد که o3 تمایل دارد اقداماتی که در فرآیند رسیدن به پاسخها انجام داده است را اختراع کند. بهعنوان مثال، Transluce مشاهده کرد که o3 ادعا کرد که کدی را روی یک مکبوک پرو 2021 «خارج از ChatGPT» اجرا کرده و سپس اعداد را به پاسخ خود کپی کرده است. در حالی که o3 به برخی ابزارها دسترسی دارد، اما نمیتواند چنین کاری انجام دهد.

چالشهای پیش روی دقت

نیل چودری، کارمند پیشین OpenAI، گفت: «فرضیه ما این است که نوعی یادگیری تقویتی که برای مدلهای سری o استفاده میشود، ممکن است مشکلاتی را تشدید کند که معمولاً با استفاده از خطوط لوله استاندارد پس از آموزش کاهش مییابند.» سارا شوئتمن، یکی از بنیانگذاران Transluce، اضافه کرد که نرخ توهم o3 ممکن است آن را کمتر مفید از آنچه که باید، کند.

کیران کاتانفروش، استاد پارهوقت استنفورد و مدیرعامل استارتاپ کارآموزی Workera، گفته است که تیمش در حال حاضر در حال آزمایش o3 در جریانهای کدنویسی خود هستند و آن را یک گام بالاتر از رقبای خود یافتهاند. با این حال، کاتانفروش میگوید که o3 تمایل دارد لینکهای وبسایتهای خراب را توهم کند. این مدل لینکی را ارائه میدهد که وقتی روی آن کلیک میشود، کار نمیکند.

راهحلهای بالقوه

توهمات ممکن است به مدلها کمک کنند تا به ایدههای جالبی برسند و در «تفکر» خود خلاق باشند، اما همچنین برخی مدلها را برای کسبوکارها در بازارهایی که دقت از اهمیت بالایی برخوردار است، سخت میکنند. بهعنوان مثال، یک شرکت حقوقی احتمالاً از مدلی که اشتباهات فاحشی را در قراردادهای مشتریان وارد میکند، راضی نخواهد بود. یکی از رویکردهای امیدوارکننده برای افزایش دقت مدلها، دادن قابلیت جستجو در وب به آنها است. GPT-4o OpenAI با جستجوی وب در آزمون SimpleQA به 90 درصد دقت دست مییابد، که یکی دیگر از معیارهای دقت OpenAI است.

اگر واقعاً مقیاسگذاری مدلهای استدلالی به بدتر شدن توهمات ادامه دهد، این امر جستجوی راهحل را بهطور جدیتری ضروری خواهد کرد. نیکو فلیکس، سخنگوی OpenAI گفت: «پرداختن به توهمات در تمام مدلهای ما یک حوزه تحقیقاتی در حال انجام است و ما بهطور مداوم در حال کار بر روی بهبود دقت و قابلیت اطمینان آنها هستیم.»

در سال گذشته، صنعت گسترده هوش مصنوعی به تمرکز بر روی مدلهای استدلالی تغییر جهت داده است، پس از آنکه تکنیکهای بهبود مدلهای سنتی هوش مصنوعی شروع به نشان دادن بازدههای کاهشی کردند. استدلال عملکرد مدل را در مجموعهای از وظایف بدون نیاز به مقادیر زیادی از محاسبات و دادهها در طول آموزش بهبود میبخشد. با این حال، بهنظر میرسد که استدلال همچنین ممکن است به افزایش توهمات منجر شود و این یک چالش به شمار میرود.